Professor Olof Sundin varnar för att generativ AI undergräver vår grundläggande förmåga att värdera information.

När källorna försvinner och svaren baseras på sannolikhetsberäkningar riskerar vi att förlora vår källkritik.

— Det vi ser är ett paradigmskifte i hur vi traditionellt söker, värderar och förstår information, konstaterar Sundin, professor i bok- och bibliotekskunskap vid Lunds universitet.

När vi googlar får vi upp länkar till källor som vi, om vi vill, kan granska och bedöma trovärdigheten hos. I språkmodeller som Chat GPT får användaren ett färdigt svar, men källorna blir ofta osynliga och inte sällan helt frånvarande.

— Svaret är baserat på sannolikhetsberäkningar av de ord du är intresserad av, inte på verifierbara uppgifter. De här språkmodellerna gissar vilka ord som sannolikt kommer härnäst, förklarar Olof Sundin.

Utan källor försvinner transparensen och ansvaret för att värdera informationen som presenteras hamnar helt på användaren.

— Det är väldigt svårt att värdera kunskap utan källor om du inte kan ämnet, eftersom det är ett källkritiskt uppdrag, förklarar han.

"Mer beroende av systemen"

Vissa AI-system har försökt möta kritiken genom RAG (Retrieval Augmented Generation), där språkmodellen sammanfattar information från faktiska källor, men forskning vittnar om ett oroande mönster.

— Studier från till exempel Pew Research Institute visar att användarna är mindre benägna att följa länkarna än tidigare. Färre klick på ursprungliga källor, som bloggar, tidningar och Wikipedia, hotar det digitala kunskapsekosystemet, argumenterar Sundin.

— Det har troligen alltid varit så att vi ofta söker efter svar och inte källor. Men när vi får enbart svar och inga källor blir vi sämre på källkritik och mer beroende av systemen.

Forskning visar även att människor själva underskattar hur stor tilltro de faktiskt har till AI:n svar.

— Människor säger ofta att de bara litar på AI när det gäller enkla frågor. Men forskning visar att de i vardagen faktiskt litar mer på AI än vad de tror, konstaterar professorn.

Sårbart för påverkan

Hur språkmodeller tränas och modereras kan göra dem sårbara för påverkan och Sundin uppmanar alla användare att fundera över vem som bestämmer hur språkmodellerna faktiskt tränas, på vilka texter och med vilket syfte.

Generativ AI har också en tendens att ofta ge felaktiga svar som ser ”seriösa” och korrekta ut, vilket kan skada tilliten till kunskap i samhället.

— När tilliten urholkas finns en risk att man börjar misstro allt och då kan man resonera som så att man lika gärna kan tro på vad man vill, fortsätter Olof Sundin.

Professorn ser en stor fara för två nödvändiga förutsättningar för att kunna utöva sina demokratiska rättigheter – källkritiskt tänkande och förmågan att värdera olika röster.

— När flödet av kunskap och information blir mindre transparent – att vi inte förstår varför vi möter det vi möter online – riskerar vi att tappa den förmågan. Detta är en fråga vi måste ta på allvar – innan vi låter våra ’digitala vänner’ ta över helt, avslutar han.

Språkmodeller

AI-tjänster som ChatGPT bygger på språkmodeller (till exempel GPT-4) som är tränade på enorma textmängder. Modellen förutsäger vilket ord som sannolikt kommer härnäst i en mening, baserat på mönster i språkanvändning.

Den "vet" inte vad som faktiskt är sant – den "gissar" vad som är rätt utifrån sannolikhetsberäkningar.

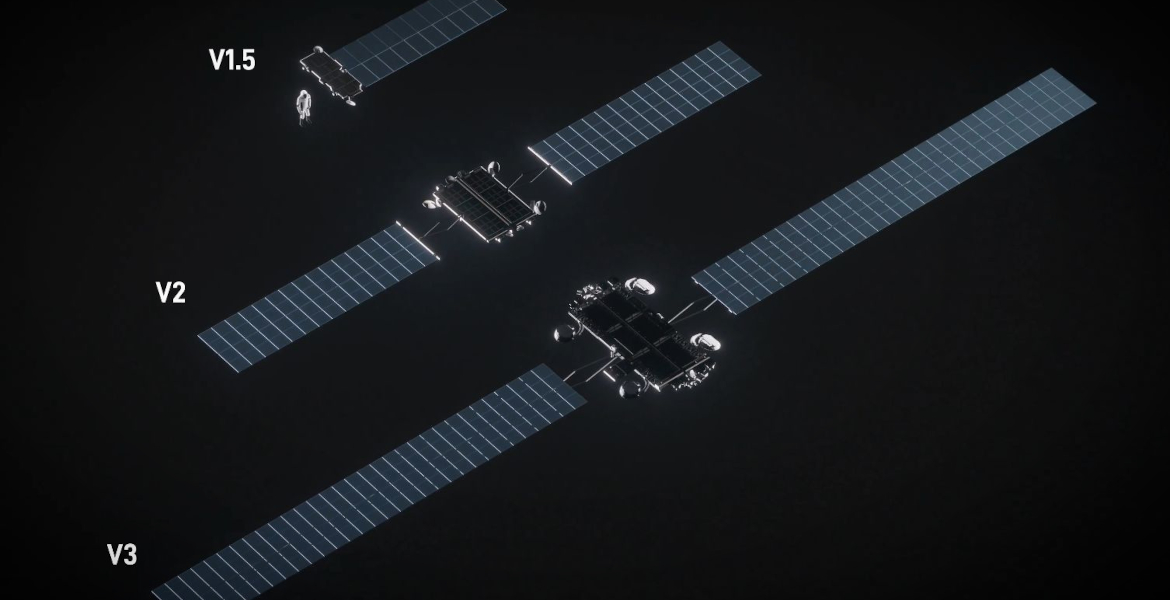

RAG (Retrieval-Augmented Generation)

RAG kombinerar AI-genererade svar med information hämtad från verkliga källor, till exempel de tre översta länkarna i en Google-sökning.

Metoden ger bättre transparens än AI-tjänster som svarar helt utan källhänvisningar, men studier visar att användarna trots detta klickar allt mindre på länkarna till originalkällorna.