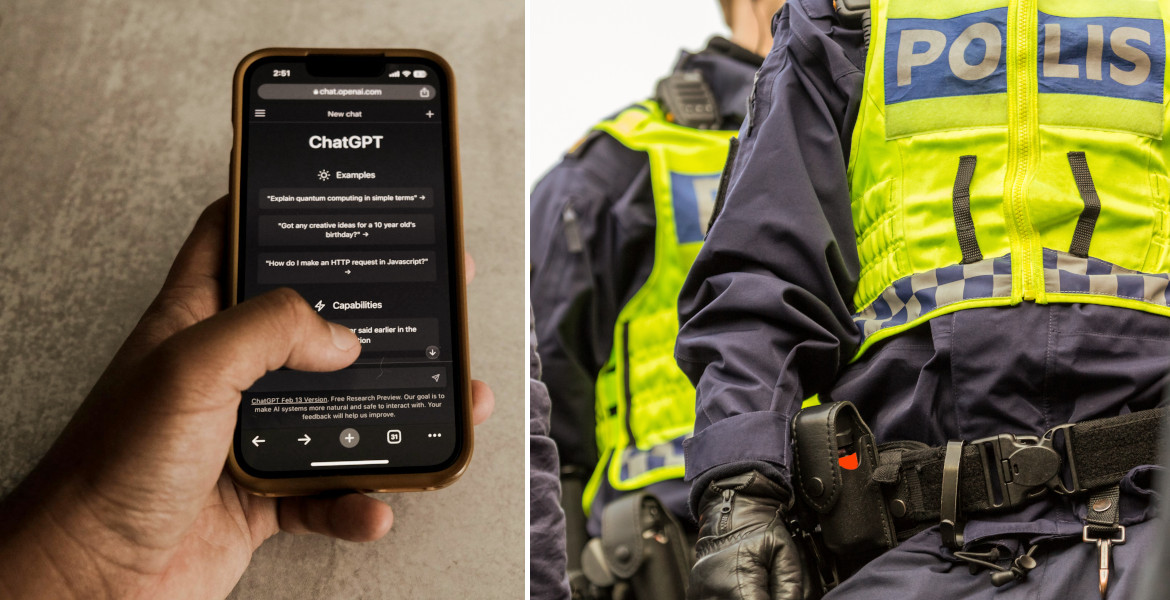

OpenAI har i tysthet börjat övervaka användarnas ChatGPT-konversationer och kan rapportera innehåll till polismyndigheter.

Avslöjandet kommer efter incidenter där AI-chatbottar kopplats till självskadebeteende, vanföreställningar, sjukhusinläggningar och självmord – vad experter kallar "AI-psykoser".

I ett blogginlägg erkänner företaget att de systematiskt scannar användarnas meddelanden. När systemet upptäcker användare som planerar att skada andra dirigeras konversationerna till ett granskningsteam som kan stänga av konton och kontakta polisen.

"Om mänskliga granskare fastställer att ett ärende gäller ett omedelbart hot om allvarlig fysisk skada mot andra kan vi skicka det vidare till rättsliga instanser", skriver OpenAI.

Den nya policyn innebär i praktiken att miljontals användare får sina konversationer skannade och att vad många uppfattat som privata samtal med en AI är nu föremål för systematisk övervakning där innehåll kan vidarebefordras till myndigheterna.

Teknikjournalisten Noor Al-Sibai på Futurism påpekar att OpenAI:s uttalande är "kort och vagt" och att företaget inte specificerar exakt vilka typer av konversationer som kan leda till polisanmälan.

"Det förblir oklart exakt vilka typer av chattar som kan resultera i att användarkonversationer flaggas för mänsklig granskning, än mindre att de rapporteras till polisen", skriver hon.

Säkerhetsproblem ignoreras

Ironiskt nog har ChatGPT visat sig sårbar för "jailbreaks" där användare kunnat lura systemet att ge instruktioner för att bygga neurotoxiner eller steg-för-steg-guider för självmord. Istället för att åtgärda dessa grundläggande säkerhetsbrister väljer OpenAI nu omfattande övervakning av användarna.

Övervakningen står i skarp kontrast till techbolagets agerande i rättegången mot New York Times, där företaget "bestämt avvisat" krav på att lämna ut ChatGPT-loggar med hänvisning till användarintegritet.

"Det är bisarrt att OpenAI ens nämner integritet, med tanke på att de i samma inlägg erkände att de övervakar användarnas chattar och potentiellt delar dem med polisen", konstaterar Al-Sibai.

Kan tvingas lämna ut chattar

OpenAI:s VD Sam Altman har nyligen erkänt att ChatGPT inte erbjuder samma sekretess som samtal med verkliga terapeuter eller advokater och på grund av rättegången kan företaget tvingas lämna ut användarchattar till olika domstolar.

"OpenAI sitter i en rävsax", skriver Al-Sibai. Företaget försöker hantera PR-katastrofen från användare som drabbats av mentala hälsokriser, men eftersom de "uppenbarligen har problem med att kontrollera sin egen teknik" faller de tillbaka på "tung moderation som går emot deras egen VD:s löften".

Techbolaget meddelar att de "för närvarande inte" rapporterar självskadefall till polisen, men formuleringen antyder att även detta kan kan komma att ändras. Företaget har heller inte svarat på förfrågningar om att förtydliga vilka kriterier som används för övervakningen.